Your browser does not fully support modern features. Please upgrade for a smoother experience.

Please note this is an old version of this entry, which may differ significantly from the current revision.

在基于无人机的目标跟踪领域,利用红外模态可以提高跟踪器在光照变化和遮挡严重的场景中的鲁棒性,扩展无人机目标跟踪任务的适用场景。受Transformer结构在RGB目标跟踪领域巨大成就的启发,可以设计一种基于Transformer的双模态目标跟踪网络。

- RGBT tracking

- Drone based object tracking

- transformer

- feature aggregation

1. 引言

目标跟踪是计算机视觉的基础任务之一,已广泛应用于机器人视觉、视频分析、自动驾驶等领域[1]。其中,无人机场景是目标跟踪的重要应用场景,助力无人机在城市治理、森林消防、交通管理等领域发挥关键作用。给定目标的初始位置,对象跟踪是在后续视频帧中捕获目标。由于大型可见光图像数据集的可用性[2],基于可见光的目标跟踪算法近年来取得了重大进展并取得了最先进的成果。目前,由于无人机任务的多样化,可见物体跟踪已无法满足无人机在各种应用场景中的多样化需求[3]。由于可见光成像机制的局限性,物体跟踪在很大程度上依赖于最佳光学条件。然而,在现实的无人机场景中,无人机需要在黑暗和雾气的环境中执行物体跟踪任务。在这种情况下,可见光成像条件不足,导致图像明显噪点。因此,基于可见光成像的目标跟踪算法无法正常工作。

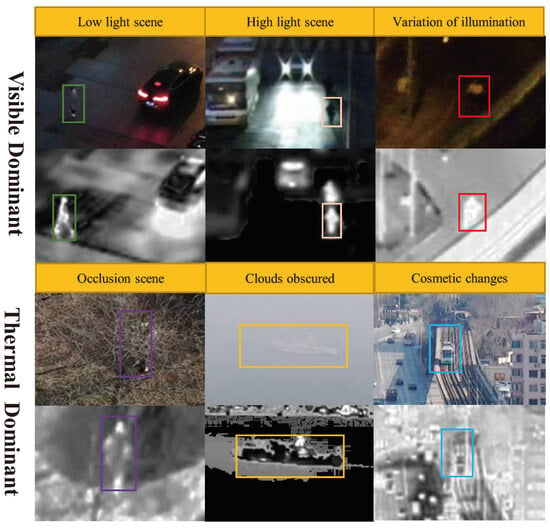

红外图像是通过测量物体发出的热量来产生的。与可见光图像相比,红外图像具有相对较差的视觉效果和互补的目标位置信息[4,5]。此外,红外图像对场景亮度的变化不敏感,因此即使在较差的闪电环境中也能保持良好的成像效果。然而,红外图像的成像质量较差,空间分辨率和灰度动态范围有限,导致图像中缺乏细节和纹理信息。相比之下,可见光图像的细节和纹理特征非常丰富。综上所述,可见光和红外目标跟踪由于红外和可见光图像的优势互补,可以满足无人机在各种场景下的任务需求,因此越来越受到关注(图1)。

图 1.这些是无人机捕获的一些可见红外图像对。在某些情况下,可见光图像可能难以区分不同的物体,而红外图像可以在这些场景中继续工作。因此,在这些情况下,来自可见光和红外模态的信息可以相互补充。引入红外模态信息对于在无人机任务中实现全面的目标跟踪非常有益。

目前,视觉对象跟踪的主要方法有两种是基于深度学习(DL)的方法和基于相关过滤器(CF)的方法[1]。基于相关滤波的方法利用快速傅里叶变换(FFT)在频域中进行相关运算,具有非常快的处理速度和实时性。然而,它们的准确性和鲁棒性很差。基于神经网络的方法主要利用神经网络强大的特征提取能力。它们的准确性优于基于相关滤波的方法,但速度较慢。随着连体网络[6,7]的提出,基于神经网络的跟踪方法的速度得到了极大的提高。近年来,基于神经网络的算法已成为目标跟踪的主流方法。

2. RGBT跟踪算法

到目前为止,已经提出了许多RGBT跟踪器[12,13,14,15]。由于RGB跟踪器发展迅速,目前的RGBT跟踪器主要考虑在RGBT跟踪任务上微调的成熟跟踪器内部的双模态信息融合问题,其中关键是融合可见光和红外图像信息。提出了几种融合方法,分为图像融合、特征融合和决策融合。对于图像融合,主流的方法是基于权重对图像像素进行融合[16\u201217],但图像融合提取的主要信息是图像对的同质信息,从红外-可见光图像对中提取异质信息的能力不强。同时,图像融合对图像对之间的配准有一定的要求,这会导致累积误差并影响跟踪性能。大多数跟踪器通过融合特征来聚合表示[18,19]。特征融合是与图像融合相比更高级的语义融合。融合要素的方法有很多种,但最常见的方法是使用权重聚合要素。特征融合具有高度的灵活性,可以用海量未配对数据进行训练,设计精良,实现显著提升。决策融合对每种模态进行独立建模,并将分数融合以获得最终的候选结果。与图像融合和特征融合相比,决策融合是更高层次的融合方法,它利用了来自可见光和红外图像的所有信息。然而,很难确定决策标准。Luo等[12]利用独立框架跟踪RGB-T数据,然后通过自适应加权将结果组合在一起。决策融合避免了不同模态的异质性,对模态注册不敏感。最后,这些融合方法也可以互补使用。例如,Zhang[11]同时使用图像融合、特征融合和决策融合进行信息融合,并在多次测试中取得了良好的结果。

3. 变压器

Transformer 起源于用于机器翻译的自然语言处理 (NLP),最近被引入视觉领域,具有巨大的潜力 [8]。受到其他领域成功的启发,研究人员利用 Transformer 进行跟踪。简而言之,Transformer 是一种在基于注意力的编码器和解码器的帮助下将一个序列转换为另一个序列的架构。注意力机制可以判断序列的哪些部分是重要的,突破了传统CNN网络的感受野限制,从输入序列中捕获全局信息。然而,注意力机制需要更多的训练数据来建立全局关系。因此,在一些样本量较小且更强调区域关系的任务中,Transformer 的影响将低于传统的 CNN 网络 [20]。此外,注意力机制能够通过在全局范围内的搜索区域中找到与模板最相关的区域来取代连体网络中的相关过滤操作。[9] 的方法应用 Transformer 来增强和融合 Siamese 跟踪中的特征,以提高性能。

4. 无人机RGB-红外跟踪

目前,可用于无人机的可见光红外物体跟踪算法很少,主要有两个原因。首先,缺乏无人机可见光红外图像的训练数据。以前,由于难以获得红外图像,使用从可见光图像生成的红外图像来训练模型。随着LasHeR[21]等数据集的出现,现在可以直接使用可见光和红外图像进行训练。此外,还有GTOT [22]、RGBT210 [23]、RGBT234 [24]等数据集可用于评估RGBT跟踪算法的性能。然而,在无人机的RGBT目标跟踪领域,只有VTUAV [11]数据集可用。由于无人机拍摄的图像与普通图像的成像视角不同,使用其他数据集训练算法不会产生良好的结果。其次,现有算法运行速度慢,难以直接使用。现有主流的RGBT目标跟踪算法都是基于深度学习的,需要同时处理可见光和红外图像,数据量大,算法结构复杂,处理速度低,如JMMAC(4fps)[25]、FANet(2fps)[18]、MANnet(2fps)[26]。在无人机场景中,无人机的RGBT目标跟踪算法对速度有很高的要求。需要简化算法结构,提高算法速度。

This entry is adapted from the peer-reviewed paper 10.3390/drones7090585

This entry is offline, you can click here to edit this entry!